מה זה קובץ רובוטס TXT? ולמה הוא חשוב לקידום אורגני?

הפעולה הבסיסית שמנועי החיפוש עושים כדי לאתר את האתר שלנו ולהציג אותו באינדקס תוצאות החיפוש, היא לסרוק אותם. ואת הפעולה הזאת הם עושים באמצעות בוטים המיועדים לסריקת אתרים.

רק כדי קצת יותר לסבר את האוזן, הבוטים של גוגל, של בינג ושאר מנועי החיפוש הנוספים, מתניידים באתר שלנו דרך קישורים פנימיים וכן באמצעות מפת ה-XML שמוטמעת באתר.

אבל מה עושים כאשר ישנם עמודים שלא מיועדים לסריקה? למשל, עמודים שהכניסה אליהם מותנית אך ורק בשם משתמש וסיסמה? או אולי עמודי ניהול שונים שבכלל אין לגולשים מה לחפש בהם כי הם מיועדים אך ורק למנהלי האתרים? כאן נכנס לתמונה קובץ אחד קטנטן שמשפיע בענק.

אז מה זה Robots.txt?

את קובץ robots.txt אני נוהג לתאר כמעין כלי עזר חשוב למנהלי אתרים שמתפקד בתור שילוט תנועה.

מנועי החיפוש מגיעים לצומת ובו יש פניות לכל מיני עמודים שונים באתר. עמודים ראשיים, עמודי קטגוריית מוצרים, עמודי מוצרים, מאמרים וכיוצא בזה.

בצומת הזאת יש לנו שילוט שמורה למנועי החיפוש איפה הם יכולים להיכנס ואיפה בעצם יש תמרור אין כניסה.

אני יודע שקצת הבאתי תיאור משונה עם הצומת שכן צומת לרוב תהיה מרומזרת, ואין בה פניות עם 'אין כניסה', אבל נמשיך עם המטאפורה. אני מניח שהבנתם את הנקודה 🙂

עבור הבוטים לסריקה של מנועי חיפוש, זהו קובץ מאוד חשוב ומשמעותי בעל השפעה עצומה על הקידום האורגני של האתר. הוא באמת ובתמים מספר להם מה מותר להם לסרוק ומה לא.

איפה הקובץ הזה נמצא?

בתכל'ס אף מקדם אתרים לא באמת יודע להטמיע את הקובץ על דרך של תכנות, וכל הפלטפורמות השונות לבניית אתרים דוגמת וורדפרס, וויקס, קונימבו, טואול וכיוצא בזאת, מאפשרות להטמיע את הקובץ דרך פיצ'ר שקיים בניהול האתר.

בוורדפרס למשל, צריך להוריד תוסף SEO כמו יואסט ודומיו, ובאמצעותו ניתן לייצר קובץ robots.txt ולאשר אותו. פעולה פשוטה ומהירה.

בפועל, אם נצלול אל הנושא, הקובץ הזה ממוקם בשורש הדומיין של האתר, כך שניתן לגשת אליו בקלות על ידי הוספת "/robots.txt" לכתובת האתר. למשל, אם כתובת האתר שלכם היא: www.example.com, אז תוכלו למצוא את הקובץ כאשר תוסיפו לדומיין את המשתנים הבאים: www.example.com/robots.txt.

תלחצו אנטר, ויוצג בפניכם הקובץ.

מנועי החיפוש מאתרים אותו בקלות ובמהירות בזמן תהליך סריקת האתר.

איך קובץ ROBOTS.TXT נראה?

קודם כל תדעו שכל פלטפורמה לבניית אתרים שיש בה פיצ'ר ליצירת רובוטס TXT, מאפשרת לבנות את הקובץ באופן אוטומטי, מבלי שאתם צריכים לכתוב דבר.

עם זאת, כן אשמח להדגים לכם את האופן שבו הוא כתוב ולהסביר על המשתנים השונים שנמצאים בו.

1. דוגמה לקובץ robots.txt שמאפשר סריקה מלאה

User-agent: *

Disallow:

מה אנחנו רואים פה?

בקובץ הזה שלפניכם אין מגבלות על סריקת האתר. הוא מתאים לאתרים שרוצים שכל התוכן יהיה גלוי למנועי חיפוש.

המונח "User-agent: *" מתייחס לפנייה שאנחנו עושים אל מנועי החיפוש והבוטים הסורקים את האתר. הסימון * משמש כפנייה לכל בוט של כל מנוע חיפוש. כך שלמעשה הכללים שלאחר מכן ניתן בהמשך הקובץ, יחולו על כל מנועי החיפוש. במילים אחרות אנחנו אומרים: 'מנועי החיפוש באשר אתם!!! להלן הכללים שלנו מה לסרוק ומה לא'.

השורה Disallow: הריקה מציינת שאין חלקים באתר שיש למנועי החיפוש איסור לסרוק. כלומר אנחנו מאפשרים להם לסרוק מכל הבא ליד.

2. דוגמה לקובץ robots.txt שחוסם את כל האתר

User-agent: *

Disallow: /

מה אנחנו רואים פה?

בקובץ זה, שימו לב שהוספתי / אחרי ה-Disallow.

המשמעות היא שאני נותן הוראה לכל הבוטים שכל התוכן באתר חסום לסריקה על ידי מנועי חיפוש.

הסימון / אחרי Disallow: מציין שכל הדפים באתר אינם ניתנים לגישה.

בקובץ כזה נשתמש באתרים בתהליכי פיתוח שנרצה לוודא שלא ייסרקו בטעות.

3. דוגמה לקובץ robots.txt שחוסם עמודים מסוימים באתר

User-agent: *

Disallow: /admin/

Disallow: /private/

מה אנחנו רואים פה?

כאן זה כבר נהיה קצת יותר מעניין.

בקובץ רובוסט TXT שלפניכם, אני אומר בעצם לבוטים שהדפים שממוקמים בתיקיות /admin/ ו-/private/ חסומים לסריקה.

זה למשל קובץ שמתאים למה שציינתי קודם עם כניסה על שם משתמש ועמודי ניהול. כאשר אנחנו רוצים להסתיר אזורים פנימיים שאינם מיועדים לציבור הגולשים.

4. דוגמה לקובץ robots.txt עם כללים פרטניים לכל מנוע חיפוש

User-agent: Googlebot

Disallow: /test/

User-agent: Bingbot

Disallow: /temp/

מה אנחנו רואים פה?

דוגמה קצת יותר פיקנטית והאמת שגם לא כל כך נפוצה. אבל אם כבר כתבתי מדריך אז אני מניח שכדאי לעשות אותו עד הסוף.

בקובץ זה מוגדרות הוראות שונות עבור מנועי חיפוש שונים. לדוגמה, Googlebot (הרובוט של גוגל) לא יורשה לסרוק את התיקייה /test/.

לצידו, ה-Bingbot (הרובוט של בינג) לא יורשה לסרוק את התיקייה /temp/.

אני לא רואה סיבות מיוחדות למנוע את זה ממנועי חיפוש שונים, אבל אני חושב שהדוגמה הזאת טובה כדי להפיל אסימונים בנוגע לתפעול של Robots.txt.

5. ולסיום - פרט קטן שנהוג לשלב בקובץ הזה

זוכרים שאמרתי שיש גם מפת אתר שמסבירה למנועי החיפוש מהם עמודי האתר ומקלה עליהם את הסריקה?

אז לרוב נהוג לשלב בתוך הקובץ גם סיומת Sitemap ולאחריה לשים את כתובת ה-URL של מפת האתר.

להזיק זה לא מזיק. כולם עושים את זה, וגם אני. כמה שיותר להקל על מנועי החיפוש.

להלן הדוגמה:

User-agent: *

Disallow:

Sitemap: https://www.example.com/sitemap.xml

האם בכך זה מסתכם?

לא בדיוק, יש עוד דוגמאות מורכבות יותר, אבל אני לרוב מייעד את המאמרים שלי עבור הקהל הרחב, קצת עבור מקדמי אתרים, ובעיקר עבור בעלי ובעלות אתרים.

אם פתאום תראו שמקדם האתרים שלכם כתב בדו"ח החודשי שהוא הטמיע קובץ robots.txt דעו שזה מה שהוא עשה.

האם Robots.txt באמת מונע ממנועי החיפוש לסרוק את האתר?

אז זהו, שזה לא הרמטי, ואנחנו לא יכולים להתחשב רק בקובץ הזה ולשער שמנועי החיפוש בהכרח יקשיבו לנו.

קובץ robots.txt אינו מונע גישה מוחלטת לתוכן! ראו בכך כאמרה חד-משמעית. לא כהנחת יסוד של מקדם אתרים אחד אל מול כאלו שאומרים אחרת.

אנחנו רק מבקשים מהבוטים שלא לסרוק אותו. אם קובץ מסוים קיים ונגיש דרך כתובת URL, ייתכן שהוא עדיין יהיה זמין דרך דפדפנים.

לכן כדאי שננקוט בצעדים נוספים. למשל אם האתר שלכם נמצא בפיתוח, אפשר גם להטמיע בקוד noindex, nofollow שמונע ממנועי החיפוש לסרוק את האתר. וכאן זה כן הרמטי. אתם חד-משמעית לא תסרקו.

הטמעת Robots.txt בתוך Google Search Console

לסיום, יש דרך נוספת להודיע לגוגל שהטמענו רובוטס TXT ואני ממליץ על כך בחום.

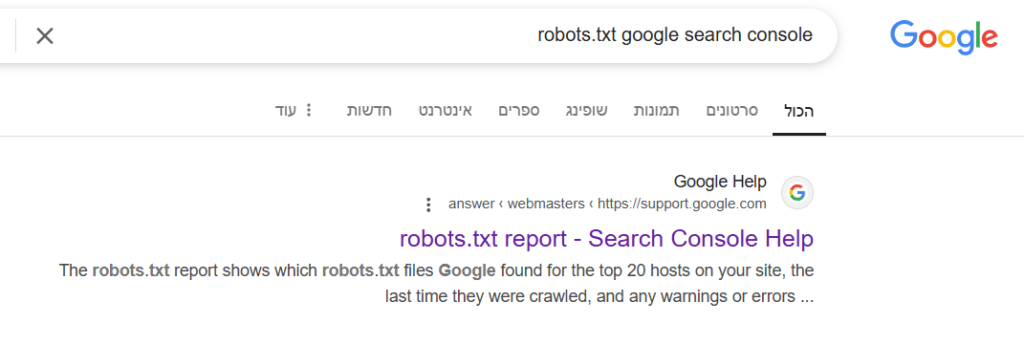

במידה והטמעתם באתר Google Search Console, גשו ללינק הבא, או תחפשו בשורת החיפוש של גוגל: robots.txt google search console ולאחר מכן תקליקו על התוצאה הראשונה:

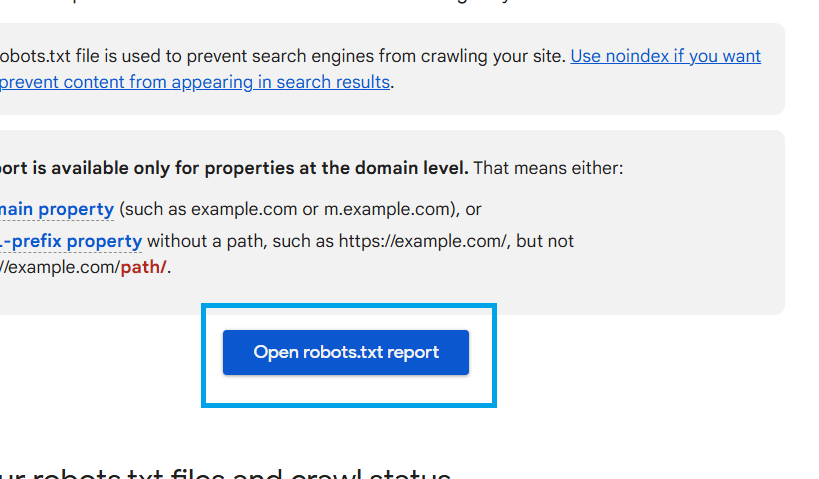

לאחר מכן, תיכנסו לעמוד מדריך של Google ובו תקליקו על הלחצן הכחול 'Open robots.txt report'

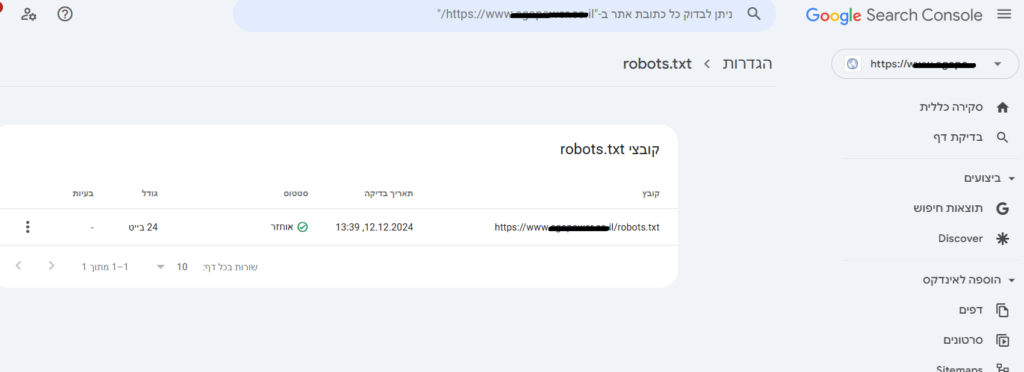

ולבסוף תגיעו לכלי שמאפשר לכם להטמיע את הקובץ ולוודא שמנוע החיפוש של גוגל אכן מבין את הקובץ שלכם כהלכה:

האם תמיד מטמיעים קובץ robots.txt בקידום אתרים?

חד-משמעית כן.

זה קובץ חשוב מאוד, שמאפשר לנו להקל על מנועי החיפוש להבין מה צריך לסרוק באתר שלנו ומה לא.

ויוצר מזה: תחשבו על תקציב הסריקה שלכם.

מנועי החיפוש מקצים לבוטים שלכם זמן עבור האתר שלכם. במידה והם יסרקו עמודים מיותרים, הרי שאתם מנצלים את תקציב הסריקה הזה עבור מטרות סרק, ואילו העמודים החשובים ביותר עבורכם, ייתכן ויתפספסו.

לא חבל? 🙂

ואם אהבתם את התוכן הזה, אז יש לי עוד הרבה ממנו להציע לכם בבלוג שלי, ובכלל – אם אתם מחפשים מקדם אתרים שילווה את האתר שלכם עד העמוד הראשון, אשמח להיות לכם לעזר.